Deep Learning 開発者を煩雑な作業から解放!

KAMONOHASHIは、Deep Learningのモデル開発を効率的に行うためのAI開発プラットフォームです。

Deep Learningのモデル開発には、複雑な環境構築・計算リソースの確保・大量に発生するデータや学習履歴の管理といった、煩雑な作業が多く存在します。KAMONOHASHIはこれらの作業を削減し、AI開発者がモデル開発に集中できる環境を提供します。

また、Deep Learningを用いたシステムを実用化する上では、実データを管理・維持しているユーザとAIのモデル開発をするユーザが別になることがあります。KAMONOHASHIのアクアリウム機能を用いると、こうしたユーザを円滑に連携することができます。

KAMONOHASHIはOSSであり、どなたでも使用することができます。AI開発プロセスを最大限効率化した、最高のモデル開発を体験してみませんか。

NEWS

-

2022/04/DDリリース

-

2021/12/01リリース

-

2021/08/31リリース

-

2021/06/30リリース

-

2021/05/31リリース

-

2018/10/21イベント

-

2018/09/19イベント

AI開発におけるこんな悩みはありませんか?

データの管理が大変

学習に使用する大量のデータファイルを、手作業で管理するのが面倒…

リソースの管理が大変

GPUはとても高額なのに、使用頻度はバラつきがあったり…効率よくリソースをシェアしたい!

学習の管理が大変

学習に使用したデータ・モデルは手作業で管理。過去の学習条件を再現するのにもひと手間…

KAMONOHASHIで解決できます

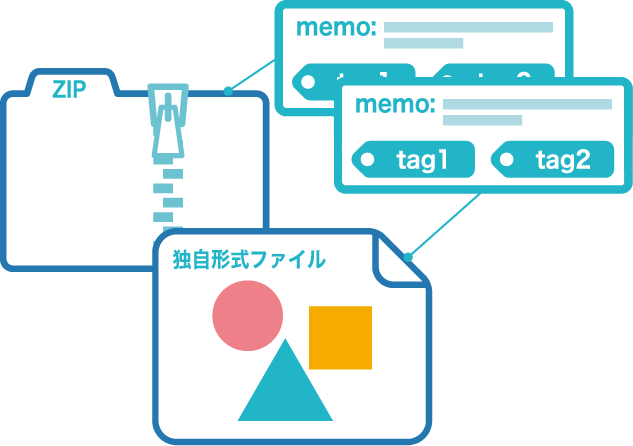

タグ・メモ機能

大量のデータは形式問わずまとめてアップロード。ひとつひとつにメモやタグをつけて整理できるためデータ検索が容易です。

リソース一覧機能

学習用に用意されたリソースはKAMONOHASHIで一覧化。空き状況を常に確認することができ、チームでのAI開発がはかどります。

学習管理機能

学習に使用した諸々の設定は全てKAMONOHASHIが記録して一覧化。手書きや表計算ソフトでの転記はもう必要ありません。

管理も楽々

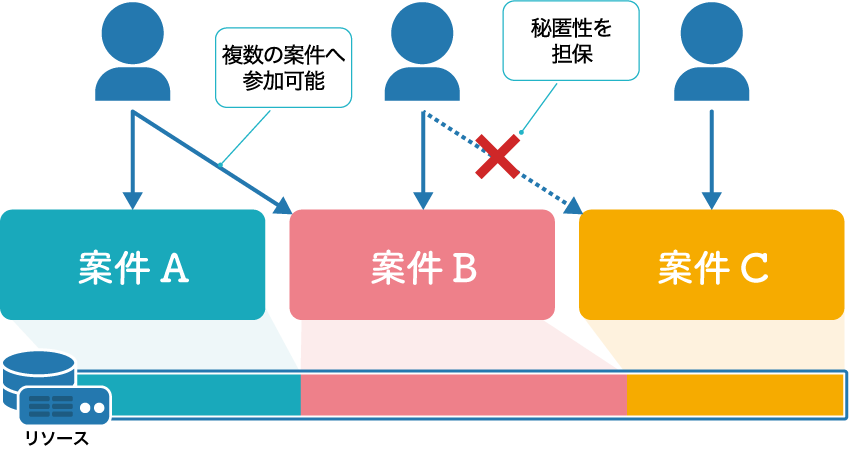

複数案件を同居

KAMONOHASHIはマルチテナント方式で構成されます。管理者がユーザごとに案件参加権限を付与することで、案件やチーム間でストレージや計算環境などのリソース共有を実現します。

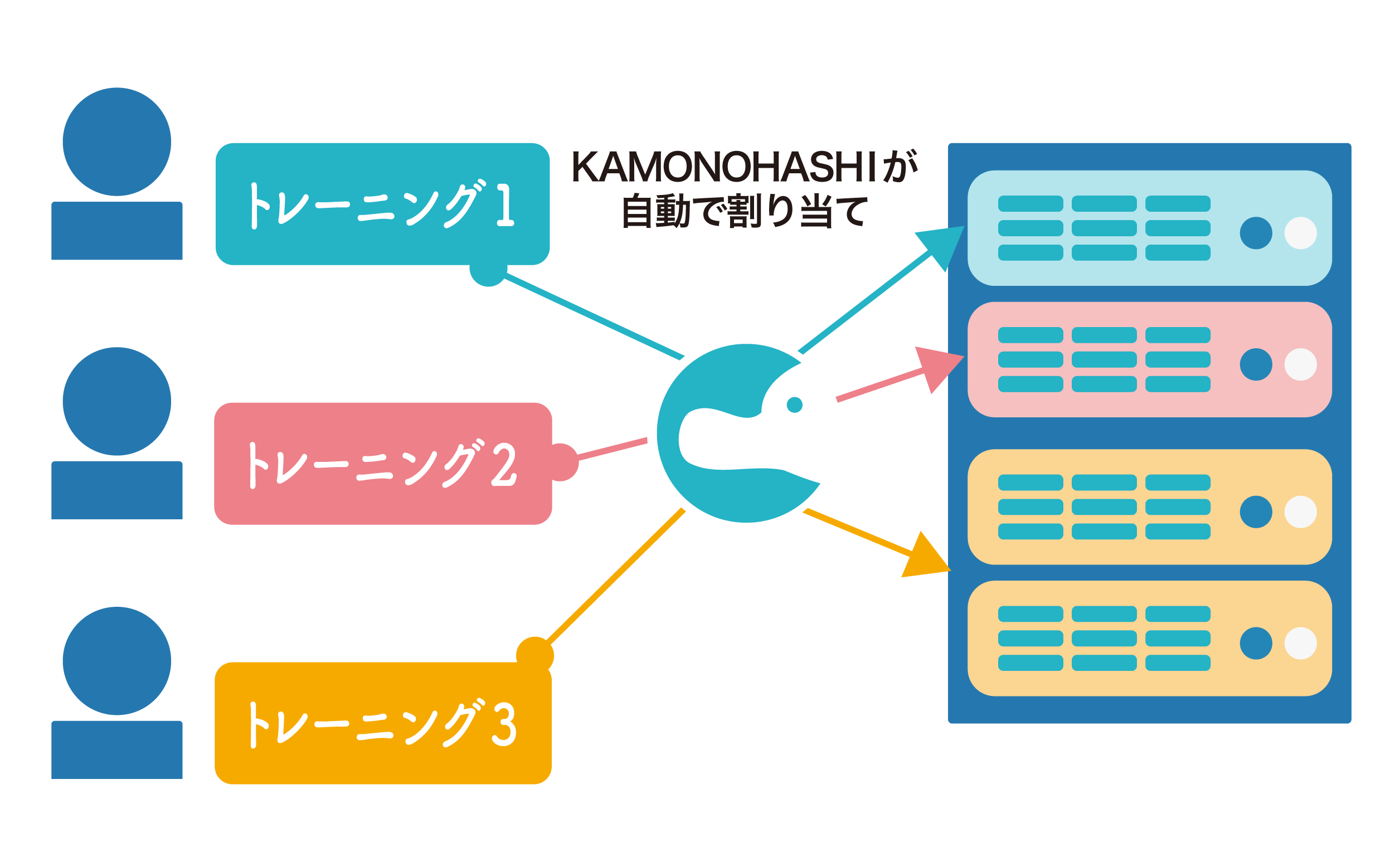

計算リソース稼働率の最適化

KAMONOHASHIは各学習に対して、GPU単位でのリソース割り当てが可能です。リソースを最適な粒度で分割して割り振ることで稼働率を向上できます。また、特定のチームだけでリソースを独占されないように、利用上限を設定したり、ノードごとに利用できるチームを制限することも可能です。

導入実績

日本製鉄株式会社 様

人工知能(AI)の開発と適用を可能にする技術基盤「NS-DIG」にKAMONOHASHIを組み込み

住友理工株式会社 様

組織横断のAI開発環境基盤にKAMONOHASHIを導入

社内のAI開発スピードの加速と業務でのAI活用を拡大

チュートリアルやドキュメントを完備

よくあるお問い合わせ

A:問題ありません。詳しくはKAMONOHASHIを活用してDeep Learning開発組織を立ち上げるためのステップをご覧ください

A:デプロイしたモデルの精度は経年・季節などの要因で劣化・変動することがあります。特に長期間・チームでのAI運用を前提としているところではモデルの管理が必要です。

A:OSSのためインストールは無償です。(インストールするためのサーバの用意が必要です。サーバは要件を満たしていればオンプレでもクラウドでも可能です。)必要に応じて有償にて導入・保守サポートを用意しています。

A:主に大手製造業を中心にご活用いただいております。

公開している導入事例はこちらをご覧ください。

A:youtubeに動画があります。デモのリクエストも受け付けています

A:何人からでもご利用になれます。弊社事例では20名程度が約10のGPUノードを共有してKAMONOHASHIを利用しています。